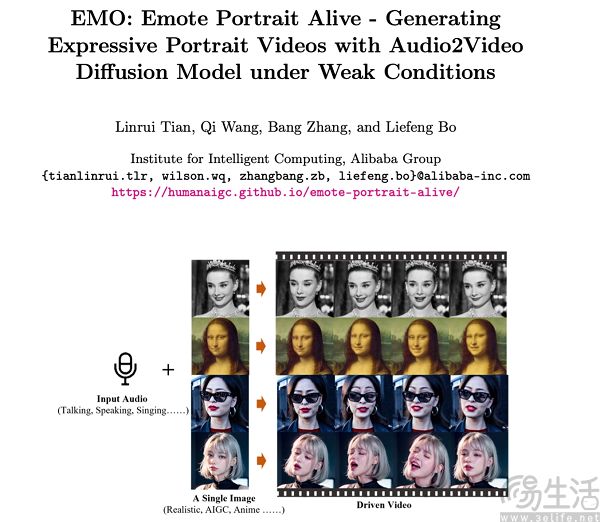

日前,阿里巴巴研究团队方面发布了一款名为“EMO(Emote Portrait Alive)”的全新AI框架,并称这是“一种富有表现力的音频驱动的肖像视频生成框架”。

据悉,该框架可以用于“对口型”,用户只需输入人物照片及音频(说话、唱歌、rap均可),就能够让照片中的人物开口说出相关音频,并支持中英韩等多种语言。而生成视频的最终长度则取决于输入音频的长度,例如让蒙娜丽莎朗诵一段独白等。

目前,阿里研究团队方面分享了几段由EMO框架生成的DEMO演示片段,并在ArXiv上发布了模型的工作原理。据介绍,EMO 基于英伟达的Audio2Video扩散模型打造,使用了超过250个小时的专业视频和超过1.5亿张图像进行训练。其训练分为图像预训练、视频训练和速度层训练三个阶段。其中在图像预训练阶段,网络以单帧图像为输入进行训练;在视频训练阶段,引入时间模块和音频层,处理连续帧;速度层训练则专注于调整角色头部的移动速度和频率。

而EMO框架的工作过程,则分为两个主要阶段。首先,研究人员利用参考网络(ReferenceNet)从参考图像和动作帧中提取特征;然后利用预训练的音频编码器处理声音并嵌入,同时结合多帧噪声和面部区域掩码来生成视频。而为了确保视频中角色身份的一致性和动作的自然流畅,该框架还融合了两种注意机制和时间模块。

对此阿里研究团队方面表示,实验结果表明,EMO不仅能够产生令人信服的说话视频,还能生成各种风格的歌唱视频,显著优于现有的先进方法,如DreamTalk、Wav2Lip和SadTalker,无论是在表现力还是真实感方面。目前,研究团队认为EMO的潜在应用方向将集中在提高数字媒体和虚拟内容生成技术水平,特别是在需要高度真实感和表现力的场景中。

【本文图片来自网络】