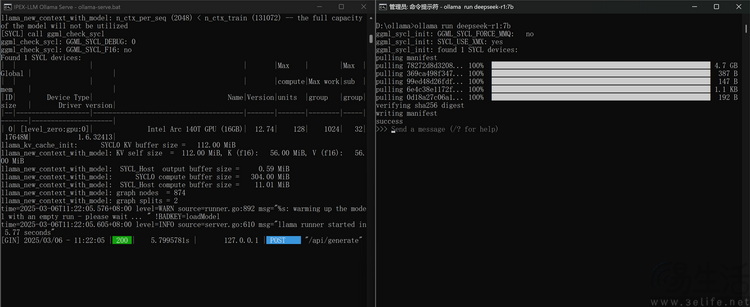

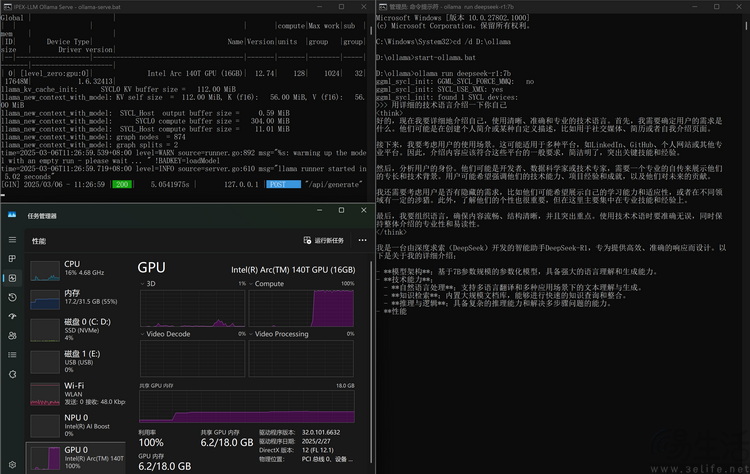

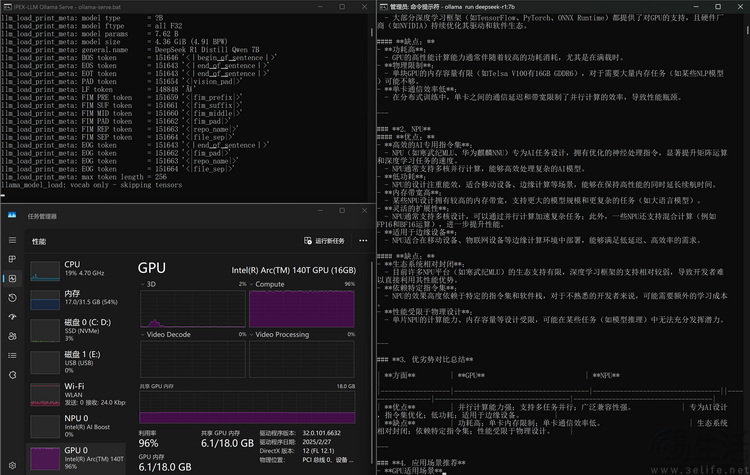

不过光有Procyon的跑分显然还不足以说明问题,所以我们还从魔搭社区下载了专为Intel平台优化过的Ollama对话模型,并基于它在这台MagicBook Pro 14上尝试进行了Deepseek-R1 7B的本地部署。

实际上,部署过程可以说相当“无脑”。只需将下载的压缩包解压,之后从CMD内将其启动,再使用命令行指定下载Deepseek-R1 7B,等自动化的下载和安装完成之后,就可以开始对话了。

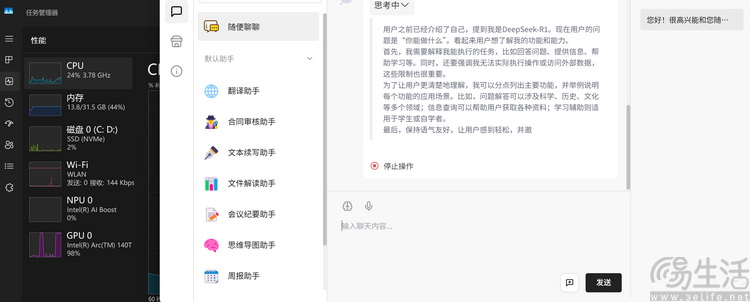

从运行效果来看,Ollama完全可以只靠ARC 140T核显的计算单元,来运行Deepseek-R1 7B这个本地大模型。在运行过程中,它的共享显存甚至也才用到1/3左右。而其回复速度和回复的复杂度,更是完全具备可用性。

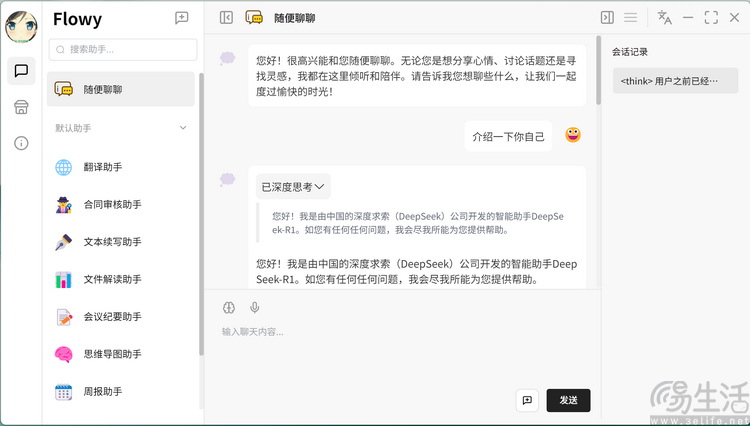

当然,众所周知的是,Ollama因为没有UI,所以在使用的便利性上确实不算高,特别是对普通用户还是不够友好。但好在现在也有一些第三方软件已经针对酷睿Ultra平台做了专门的适配。只要软件侦测到处理器符合特定的型号,就会自动“解锁”相应的本地AI处理模式。

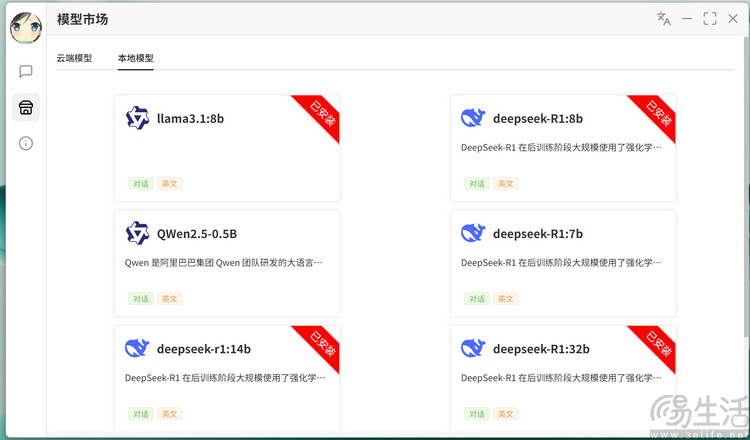

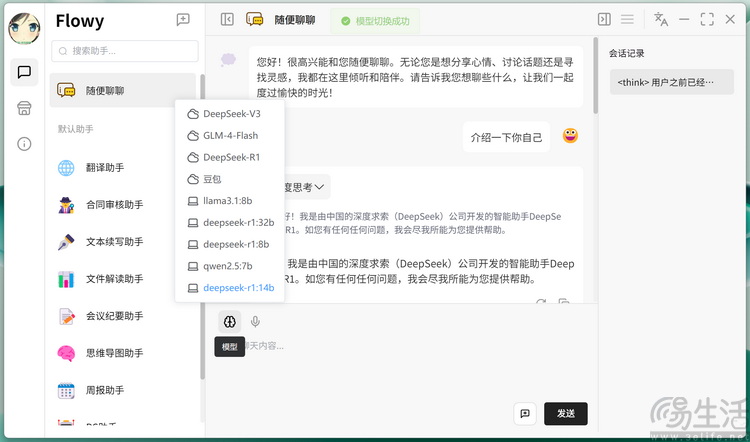

以Flowy为例,它本身就自带云端和本地两种大模型工作模式。在我们此前测试的“非AI PC”上,本地大模型虽然可以下载,但无法在对话模式下被选中。而到了酷睿Ultra平台,Flowy就允许用户切换到本地模型工作状态。

从我们实测结果来看,Magic Book Pro 14搭载的酷睿Ultra9 285H处理器搭配32GB高频内存,甚至可以“带动”14B规模的Deepseek本地大模型,在回答精度和使用便利度上都要比Ollama更上一层楼。

除了Flowy,另一个AI对话APP“智谱清言”对于酷睿Ultra平台的适配就做得更有意思。在首次启动后,它会提示可以切换到专为Intel酷睿Ultra平台适配的本地对话模式。此时,不仅原本隐藏的本地模型下载功能会自动“解锁”,甚至就连软件本身的界面都会发生改变,右上角会出现“Intel Core Ultra”的Logo,让人一眼就能看出它是专为目前的处理器做了适配。